|

Sonntag, 22. September 2019

Martinstift-Symposion am 11. Oktober im Brucknerhaus Linz zum Thema „Hart aber HERZLICH“ Engagiert begleiten - trotz harter Rahmenbedingungen.

Mittwoch, 11. September 2019

MetaTalkDE Update

Vor ein paar Tagen erschien ein MetaTalkDE Update. Was ist neu?

• Man kann nun die Auslösezeit für den langen Tastendruck anpassen (in der Einstellungen App unter MetaTalkDE).

• Das Menü zum Kopieren der Symbolpfade in der Suchfunktion und in den Popups erscheint nur noch im Editiermodus (Bleistifttaste antippen...), da dies eine Betreuerfunktion ist und es bei Nutzern manchmal zu versehentlichem Auslösen in den Popups kam.

Freitag, 6. September 2019

METACOM Stempel Autismusverlag

METACOM Stempel

Mit unserer Stempelpresse machen wir nicht nur Fremdaufträge, sondern wollen auch METACOM Symbol-Stempel herstellen. Welche Stempel würdest Du brauchen? Wir freuen uns, wenn Du uns deine Inputs bei unserer Umfrage mitgibst. Die Umfrage findest Du hier:https://findmind.ch/c/HlOXiPKK85

Mit unserer Stempelpresse machen wir nicht nur Fremdaufträge, sondern wollen auch METACOM Symbol-Stempel herstellen. Welche Stempel würdest Du brauchen? Wir freuen uns, wenn Du uns deine Inputs bei unserer Umfrage mitgibst. Die Umfrage findest Du hier:https://findmind.ch/c/HlOXiPKK85

Donnerstag, 8. August 2019

Selbstgespräche Technologie kann Gedanken lesen und hörbar machen

SelbstgesprächeTechnologiekannGedankenlesenundhörbarmachen

Nicht alle Gedanken in unserem Kopf sind für die Öffentlichkeit bestimmt. Manche würden wir aber gerne festhalten für später. Wie praktisch wäre es, dann etwas zu haben, das unsere Gedanken direkt aufzeichnet. Genau so ein Gerät hat ein 24-Jähriger jetzt entwickelt.

Alter Ego ist ein tragbares Gerät, das hörbar macht, was wir denken. Die Technologie macht sich die Tatsache zunutze, dass unser Gehirn Signale an die Stimmbänder, den Hals und die Zunge sendet – und zwar egal, ob wir laut sprechen oder nur leise in unserem Kopf Selbstgespräche führen.

Das Wearable Alter Ego kann diese Signale abgreifen und mit Hilfe einer Künstlichen Intelligenz (KI) bestimmten Worten zuordnen. Der Träger oder die Trägerin des Geräts kann dann die Transkription der Worte über ein Headset hören. Das leitet die Antworten der KI direkt durch die Gesichtsknochen ins innere Ohr, so dass sie für Außenstehende unhörbar sind.

Entwickelt hat Alter Ego der 24-jährige Forscher Arnav Kapur. Der schreibt gerade am Massachusetts Institut for Technology (MIT) seine Doktorarbeit und hat in seinem noch jungen Forscherleben schon so einiges erfunden: Er hat eine Drohne aus dem 3D-Drucker entworfen, eine Audio-Technologie entwickelt, die sehbehinderten Menschen erzählt, wie die Welt um sie herum so aussieht. Und er hat am Mondfahrzeug Indus mitgearbeitet, das Indien im September 2019 auf den Mond schicken will.

Mit Alter Ego hat Arnav Kapur gerade den "Use it!" Lemelson-MIT Student Prize für innovative Technikprodukte gewonnen.

Hilfe für Menschen mit Sprachstörungen

Arnav Kapur gibt die Genauigkeit seines Systems mit 92 Prozent an. Das hat er bei mehreren Experimenten getestet – zuletzt in verschiedenen Rehabilitationszentren in Boston. Dort hat er Alter Ego mit Menschen ausprobiert, die Sprachstörungen haben, zum Beispiel aufgrund eines Schlaganfalls oder durch geschädigte Nerven im Gehirn oder Rückenmark. Die können ihre Sprechmuskeln zwar nicht mehr richtig nutzen, aber die Hirnsignale, die sie beim Denken aussenden, sind noch zu 100 Prozent intakt. Deswegen kann das Wearable erkennen, was sie sagen wollen und das in Sprache übersetzen.

Arnav Kapur kann sich aber auch die ganz alltägliche Nutzung von Alter Ego vorstellen. Er sagt, mit seinem Device habe man das perfekte Gedächtnis. Er hofft, dass es dazu beiträgt, dass Menschen KI nicht mehr als so bedrohlich empfinden, wenn sie verstehen, wie es unser tägliches Leben bereichern kann.

Ob das tatsächlich so ist, bleibt fraglich. Denn es lässt sich leicht erkennen, wo das Missbrauchspotential liegt. Zum Beispiel, wenn die Anwendung vom Militär oder von Ermittlungsbehörden in Diktaturen genutzt würde. Bis Alter Ego auf den Markt kommt, wird es noch eine Weile dauern. Aber Arnav Kapur hat es bereits zum Patent

Dienstag, 6. August 2019

Sprachforscher Webseite

Yippie - die neue Sprachforscher Webseite ist online. Mit der Lokomotive Schorschi Schnaufi spielerisch den Sch-Laut entdecken.

Wie gefällt euch unsere neue Website?

http://www.dersprachforscher.at/index.php?id=59

Wie gefällt euch unsere neue Website?

http://www.dersprachforscher.at/index.php?id=59

Freitag, 2. August 2019

Forscher leiten Sprache aus Hirnsignalen ab

Menschen, die die Fähigkeit zu sprechen verloren haben, müssen bisher Sprachassistenten oft per Augenbewegung oder Tastatureingabe steuern. Das erlaubt zwar eine Verständigung, aber nur langsam. Eine Sprachprothese wäre eine große Hilfe.

Bisher müssen Menschen, die nicht mehr sprechen können, sich mühsam über Sprachassistenten verständigen, die sie per Augenbewegung oder Tastatureingabe steuern. Nun schaffen es Forscher, Signale des Gehirns in Sprache zu übersetzen. Nächstes Ziel: die Entwicklung einer "Sprachprothese".

Forscher sind dem Ziel vom Gedankenlesen offenbar ein Stück näher gekommen: Erstmals sei es möglich, gehörte oder gesprochene Informationen aus einer Unterhaltung anhand der Messung von Hirnaktivitäten zu entschlüsseln, berichten Wissenschaftler um Edward Chang von der University of California in San Francisco. Die Erkenntnisse sollen helfen, eine der menschlichen Kommunikation angepasste Sprachprothese zu entwickeln, schreiben die Forscher im Fachblatt "Nature Communications".

Ein deutscher Experte spricht von einer "sehr spannenden Entwicklung". Chang und seine Mitarbeiter seien weltweit führend darin, Sprache aus Hirnsignalen zu decodieren, sagt Tonio Ball von der Uniklinik Freiburg, der nicht an der Arbeit beteiligt war.

"Bedeutende Verbesserung der Lebensqualität"

Das Verfahren könnte nach Angaben von Chang und Kollegen eines Tages Menschen helfen, die wegen eines Schlaganfalls oder neurodegenerativer Erkrankungen wie etwa Amyotropher Lateralsklerose (ALS) ihre Sprechfähigkeit verloren haben. "Die Wiederherstellung begrenzter kommunikativer Fähigkeiten ist mit einer bedeutenden Verbesserung der Lebensqualität verbunden. Doch es gibt bisher keine Sprachprothese, die so schnell ist wie eine menschliche Unterhaltung", schreiben die Forscher.

Eine Sprachprothese soll Gedanken von Menschen als Sprache wiedergeben können.

(Foto: imago/Ikon Images)

Bisher müssen Betroffene Sprachassistenten oft per Augenbewegung oder Tastatureingabe steuern. Das erlaubt zwar eine Verständigung, aber nur langsam. Eine ideale Sprachprothese sollte nach Ansicht der Forscher Gedanken von Menschen als Sprache wiedergeben können - möglichst in Echtzeit.

Für ihr Programm untersuchten die Wissenschaftler drei Menschen, die wegen einer Epilepsie direkt auf dem Kortex, also der Großhirnrinde, aufliegende Elektroden-Matten trugen. Die Elektroden zeichneten die Hirnaktivität - insbesondere des Sprach- und Hörzentrums - zunächst während einer nachgestellten Unterhaltung auf. Dazu hörten die Teilnehmer Fragen wie "Welches Musikinstrument hören sie gerne?". Anschließend mussten sie aus einer vorgegebenen Auswahl von Antworten, die auf dem Bildschirm angezeigt wurde, eine wählen und sprechen - etwa "elektrische Gitarre".

Währenddessen maßen die Forscher per Elektrokortikogramm (ECoG) die elektrischen Impulse der Nervenzellen, die beim Hören und Sprechen aktiviert wurden. Aus den Messwerten bestimmte das Team mithilfe einer Software, welche Fragen die Teilnehmer gehört oder welche Antworten sie gegeben hatten. In mehr als 85 Prozent der Fälle ermittelten die Wissenschaftler korrekt, ob die Teilnehmer eine Frage gehört oder eine Antwort gegeben hatten.

Die richtige Antwort konnte das Verfahren dann zuverlässiger abschätzen, wenn bekannt war, welche Frage gestellt worden war. Je besser das Programm mit der Zeit verschiedene neuronale Muster auseinander halten konnte, desto zuverlässiger konnte es auch die Antworten vorhersagen. Insgesamt war es den Wissenschaftlern zufolge möglich, bis zu 61 Prozent der gehörten und bis zu 76 Prozent der gesprochenen Antworten richtig zu entschlüsseln. Die zufällige Trefferquote lag demnach bei 7 und bei 20 Prozent.

Nur drei Teilnehmer

Die Zahl von nur drei Teilnehmern erschwert es jedoch, generelle Schlüsse zu ziehen. Auch Aussagen, wie sich die Lage der Elektroden auswirkt, lassen sich nur schwer treffen - obwohl das den Forschern zufolge große Bedeutung haben könnte. "Weitere Verbesserungen bei der Spracherkennung würden die Leistungsfähigkeit eines Entschlüsselungsprogramms deutlich verbessern", schreibt das Team.

Trotz dieser Unsicherheit glauben die Wissenschaftler, dass die Ergebnisse ein wichtiger Schritt hin zu einer Sprachprothese sind. "Die Ergebnisse zeigen, dass es möglich ist, Sprache in Echtzeit und während einer Unterhaltung zu entschlüsseln", schreiben sie. "Das hat eine große Bedeutung für Patienten, die nicht in der Lage sind, sich zu verständigen."

"Konzeptionell und handwerklich sehr gute Arbeit"

Der Freiburger Experte Ball von der Klinik für Neurochirurgie spricht von einer konzeptionell und handwerklich sehr guten Arbeit. "Das Innovative ist, dass man sich an der natürlichen Kommunikation orientiert hat", sagt der Neurologe. "Der Wechsel von Frage und Antwort hilft dabei, Hirnsignale zuverlässig zu interpretieren."

Die Studie biete einen Fortschritt, allerdings gebe es noch viel Spielraum nach oben. Optimieren lasse sich etwa die Aufzeichnung der neuronalen Muster beim Hören und Sprechen - dafür seien die Elektroden-Matten für Epilepsie-Patienten nicht ausgelegt. "Die Technologie ist noch lange nicht ausgereizt", sagt Ball. Auch könnten Methoden der Künstlichen Intelligenz die Auswertung der Hirnsignale möglicherweise noch deutlich verbessern.

Freitag, 26. Juli 2019

Berufsbegleitender Diplomlehrgang Unterstützte Kommunikation

Ein neuer nebenberuflicher Studiengang zur Unterstützen Kommunikation in Österreich.

Im November 2019 startet equalizent einen mehrmonatigen Diplomlehrgang für Unterstützte Kommunikation.

Sich mit anderen Menschen auszutauschen und mit ihnen zu kommunizieren, ist ein Grundbedürfnis und eine Notwendigkeit.

Doch es gibt Menschen, die aufgrund von Behinderung, Alter oder Krankheit nur eingeschränkt mit ihrer Umwelt in Kontakt treten können. Ein Weg für diese Menschen, an der Gesellschaft teilhaben zu können, ist die Unterstützte Kommunikation.

equalizent veranstaltet vom 8. November 2019 bis zum 19. Juni 2020 einen berufsbegleitenden Diplomlehrgang zur Unterstützten Kommunikation. Dieser Kurs ist als Zusatzqualifikation zum Beispiel im pädagogischen Feld, in Altenheimen, Tages- und Wohneinrichtungen gedacht.

Der Lehrgang beinhaltet unter anderem eine Einführung in Unterstütze Kommunikation, Gebärden sowie elektronische und nicht-elektronische Kommunikationshilfen. Er endet mit dem Verfassen einer Diplomarbeit und einem Fachgespräch. Die Kurskosten belaufen sich auf 2.800 Euro.

equalizent ist ein Unternehmen mit langjähriger Erfahrung im Bereich Gehörlosigkeit und Diversitymanagement.

Warum auch Unterstützte Kommunikation für sie ein Thema ist, darüber sagt Monika Haider, Geschäftsführerin von equalizent:

Man kann nicht nicht kommunizieren meinte schon Paul Watzlawick. Neben der Wortsprache gibt es eben auch verschiedene andere Wege der Kommunikation: Körpersprache, unterstützte Gebärden, Mimik, aber auch verschiedene technische Tools.Als Diversity Unternehmen möchten wir uns nicht auf das Thema Gehörlosigkeit beschränken, sondern uns breiter für eine inklusive Gesellschaft einsetzen. Kommunikation ist dafür ein Schlüsselelement.

Weitere Details zum Diplomlehrgang inklusive der Anmeldungsmöglichkeit finden Sie auf der Homepage von equalizent.

Anmeldeschluss ist Ende Oktober 2019. Die Teilnehmerzahl ist auf 14 Personen begrenzt.

Samstag, 20. Juli 2019

Vortrag Unterstützte Kommunikation in der Öffentlichkeit beim IKT Forum

mir macht das Vorträge halten auf der Uni viel Spaß 😉😉

Sonntag, 14. Juli 2019

Dienstag, 9. Juli 2019

Vortrag Unterstütze Kommunikation in der Öffentlichkeit

Morgen ist es soweit ich präsentiere meinen Vortrag unterstützte Kommunikation in der Öffentlichkeit ich bin gespannt was für ein Feedback ich bekommen werde

Montag, 8. Juli 2019

Montag, 1. Juli 2019

Freitag, 28. Juni 2019

Uk + schimpfen

Dienstag, 11. Juni 2019

capito App: Die wichtigsten Nachrichten des Tages lesen

| ||||||||||

|

Montag, 10. Juni 2019

Eis bestellen mit I Pad selbst bestellt schmeckt es am besten

für die Vielleicht noch nicht so mutigen UK Nutzer oder Eltern von UK Nutzern traut euren Kindern was zu es gibt auch leute die einem mit Sprachcomputer zuhören

Freitag, 31. Mai 2019

Video zum Thema wie findet ihr es, wenn ihr wen seht mit einem Sprachcomputer

die Schule SOB Gallneukirchen ( Schule für Sozialbetreuungsberufe hat mich bei diesem Video tatkräftig unterstützt

auch auf diesem Weg möchte ich mich nochmal bei euch bedanken

Mittwoch, 15. Mai 2019

Buch lesen mit Metatalk

Ich hatte wieder mal Lust für euch ein Video zu drehen da ich schon länger keins mehr gedreht habe . ich habe mir das Thema Buch lesen mit Metatalk ausgesucht wie ihr seht es funktionert ich habe jetzt das Raster 6*11 das Bücher lesen gestaltet sich etwas schwierig damit aber in Alltagssituationen bin ich schon ganz fit im neuen Vokabular weil ich ein Buch ausgesucht habe wo ein paar Wörter drin waren habe ich ziemlich viel die Suchfunktion verwendet

aber ich denke das ich die Suchfunktion verwendet habe ist nicht schlimm so könnt ihr sehen das es eine Suchfunktion gibt ☝☝☝☝☝☝😀😀😀😀😀😀😀😀😀😀😀😀😀😀💬💬💬💬💬💬💬💬💬💬💬💬

viel Spaß beim Anschauen wünscht euch eure

aber ich denke das ich die Suchfunktion verwendet habe ist nicht schlimm so könnt ihr sehen das es eine Suchfunktion gibt ☝☝☝☝☝☝😀😀😀😀😀😀😀😀😀😀😀😀😀😀💬💬💬💬💬💬💬💬💬💬💬💬

viel Spaß beim Anschauen wünscht euch eure

Anja

Freitag, 10. Mai 2019

Aufbaukurs UK und Technische Hilfen

Juhu ich habe wieder einen Abschnitt geschafft jetzt fehlen mir nur noch 2 kurse bis zum Abschluss – glückselig.

Tagesablauf mit symbolen

Ich finde diese Beschriftungen sehr hilfreich für uk Nutzer die lesen können Könnern den Tagesablauf lesen und für die Symbole für das Verständnis brauchen kommen auch nicht zu kurz

ich finde Lifetool setzt das perfekt um

ab und zu wäre das in unserer Arbeit auch nicht schlecht

ich finde Lifetool setzt das perfekt um

ab und zu wäre das in unserer Arbeit auch nicht schlecht

Samstag, 4. Mai 2019

Recht auf Kommunikation

Am 5.Mai ist Europäischer Protesttag zur Gleichstellung von Menschen mit Behinderung.

Immer wieder weisen sie auch selber drauf hin: "Wir sind nicht sprachlos, aber wir brauchen einen Rechtsanspruch auf Technische Hilfsmittel!" - #RechtAufKommunikation

Immer wieder weisen sie auch selber drauf hin: "Wir sind nicht sprachlos, aber wir brauchen einen Rechtsanspruch auf Technische Hilfsmittel!" - #RechtAufKommunikation

Donnerstag, 2. Mai 2019

Vortrag

Da ich am 24.5. Wieder einen Vortrag habe habe ich mir diesmal was besonderes einfallen lassen zum Thema wie findet ihr es(Schüler) wenn ihr wen mit sprachcomputer seht? Ich werde ein kleines Video.drehen dazu.natürlich mit Einverständnis der schüler da ein paar gezeigt werden und als Dankeschön bekommen sie von mir eine Urkunde

Einkaufen und Gutes tun - LIFEtool ist Partner von shop2help

shop2help.net ist ein Partner von amazon und als solcher an jedem Umsatz von amazon beteiligt, der über shop2help.net generiert wird. Die dabei ausgeschüttete Provision wird zum größten Teil an NGOs als Spende weitergegeben. So profitiert auch LIFEtool - OHNE jegliche Mehrkosten für Sie.

Einfach auf nachfolgenden Link klicken und shoppen - viel Spaß und DANKE!

Mittlerweile beteiligen sich auch viele weitere Onlineshops bei shop2help wie Libro, Lufthansa und andere Flugportale oder auch Bekleidungsshops wie Tom Tailor und viele mehr.

Sie müssen nur über den Link einsteigen, den jeweiligen Shop anklicken und schon können Sie wie gewohnt einkaufen. Selbstverständlich bleiben Ihre Daten anonym; es wird lediglich der Betrag ohne Angabe von Namen oder sonstigen Informationen überwiesen.

Freitag, 19. April 2019

So verhinderst du, dass deine Alexa-Befehle mitgehört werden!

So verhinderst du, dass deine Alexa-Befehle mitgehört werden!

- Sponsorenliebe | Werbung -

Wir berichteten darüber erst vor wenigen Tagen, dass Amazons Sprachassistent „Alexa“ die Sprachbefehle aufzeichnet, welche dann teilweise von Mitarbeitern abgehört wurden.

in Kommentar.

Dieser Artikel zum Anhören

Dies konnte man sich eigentlich schon denken, da in der Alexa-App selbst steht, dass die Befehle zur Verbesserung der Qualität aufgezeichnet werden, doch ist jetzt erst sicher, dass dies durch Mitarbeiter geschieht, nicht durch einen Algorithmus.

Wie funktioniert die Sprachaufzeichnung?

Das Amazon Echo, so der offizielle Name, hat dauerhaft ein „offenes Ohr“, um zu hören, wann der Befehl „Alexa“ gesprochen wird. Dafür hat das Gerät einen internen Speicher, in dem immer wenige Sekunden der Gesprächsumgebung gespeichert und wieder gelöscht werden.

Wenn nun der voreingestellte Befehl „Alexa“ ausgesprochen wird, beginnt das Echo mit der Aufzeichnung, erkennbar an dem blauen Rand oben am Gerät. Diese Aufzeichnung, welche eventuell auch noch wenige Sekunden des Gespräches vorher enthält, wird dann an die Amazon-Server gesandt und teilweise ausgewertet.

„Ich möchte das aber nicht!“

Als Nutzer kannst du allerdings bestimmen, ob deine Sprachbefehle auf den Amazon-Servern gespeichert und ausgewertet werden! Wir zeigen dir hier, wo du die Einstellungen dafür findest!

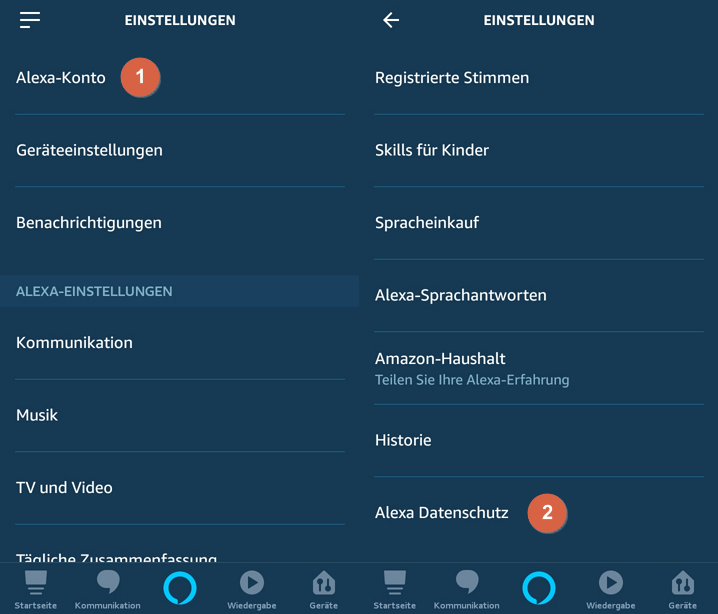

Dazu öffnest du die Alexa-App und gehst in die Einstellungen (die drei Striche oben links).

Folgend tippst du zuerst auf „Alexa-Konto“ [1] und dann auf „Alexa Datenschutz“ [2].

Folgend tippst du zuerst auf „Alexa-Konto“ [1] und dann auf „Alexa Datenschutz“ [2].

Unter dem Datenschutzpunkt findest du eine Menge interessanter Sachen, beispielsweise deine letzten Befehle an Alexa. Interessanterweise auch Aufnahmen, die automatisch gelöscht wurden, mit dem Vermerk „Text nicht verfügbat – Audio war nicht für Alexa bestimmt„.

Uns interessiert nun aber der Punkt, um die Speicherung zu verhindern!

Uns interessiert nun aber der Punkt, um die Speicherung zu verhindern!

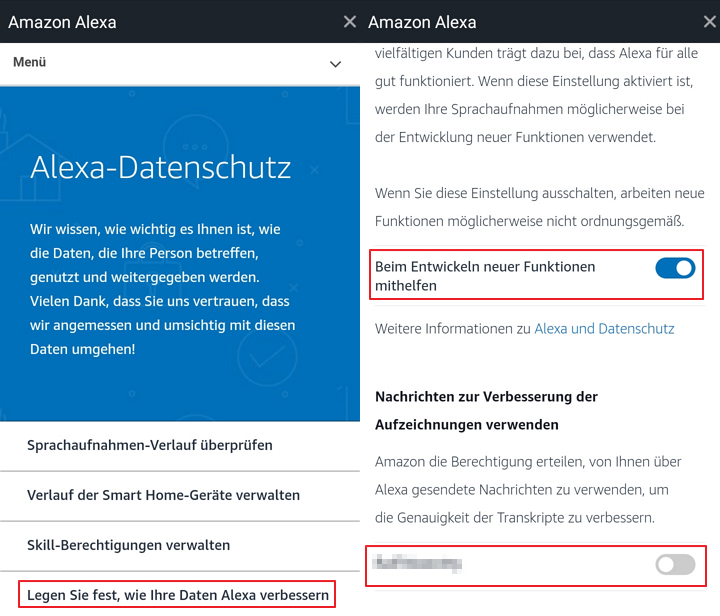

Dafür tippst du auf „Legen Sie fest, wie Ihre Daten Alexa verbessern sollen„.

Dort findest du dann zwei Einstellungen, die du deaktivieren kannst: „Beim Entwickeln neuer Funktionen mithelfen“ und „Nachrichten zur Verbesserung der Aufzeichnung verwenden„.

Dort findest du dann zwei Einstellungen, die du deaktivieren kannst: „Beim Entwickeln neuer Funktionen mithelfen“ und „Nachrichten zur Verbesserung der Aufzeichnung verwenden„.

Eine Einschränkung der Funktionen musst du bei der Deaktivierung beider Punkte nicht befürchten, einzig bei ganz neuen Funktionen könnte es zu Fehlern kommen. In der Praxis ist uns das bisher allerdings nicht aufgefallen.

Donnerstag, 11. April 2019

SprachforscherApp

#SprachforscherApp

Die neue Sprachforscher-App, die wir gemeinsam mit dem TRAUNER Verlag - Bildung und der FH Gesundheitsberufe OÖ entwickelt haben, unterstützt Kinder dabei, die komplexen Vorgänge des Sprechens spielerisch zu erlernen.👍

#traunerbildung #bildungdiebegeistert #LIFEtool

Die App Der Sprachforscher gibt es in zwei Varianten:

"Der Sprachforscher – Logopädie" wendet sich an Logopädinnen und andere Sprachförderkräfte mit therapeutischem Hintergrund und spezifischem Fachwissen zu Spracherwerb und dessen Problemen. Die App möchte Ihnen ein modernes Hilfsmittel in die Hand geben, das im Rahmen der Therapie als zusätzliches Material eingesetzt werden kann. "Der Sprachforscher für Kinder" ist für den Einsatz zuhause oder in Hort und Kindergarten gedacht.

Die neue Sprachforscher-App, die wir gemeinsam mit dem TRAUNER Verlag - Bildung und der FH Gesundheitsberufe OÖ entwickelt haben, unterstützt Kinder dabei, die komplexen Vorgänge des Sprechens spielerisch zu erlernen.👍

#traunerbildung #bildungdiebegeistert #LIFEtool

Die App Der Sprachforscher gibt es in zwei Varianten:

"Der Sprachforscher – Logopädie" wendet sich an Logopädinnen und andere Sprachförderkräfte mit therapeutischem Hintergrund und spezifischem Fachwissen zu Spracherwerb und dessen Problemen. Die App möchte Ihnen ein modernes Hilfsmittel in die Hand geben, das im Rahmen der Therapie als zusätzliches Material eingesetzt werden kann. "Der Sprachforscher für Kinder" ist für den Einsatz zuhause oder in Hort und Kindergarten gedacht.

Donnerstag, 4. April 2019

Schule für Sozialbetreuungsberufe

Ich bereite mich auf meinen nächsten vortrag über unterstützte Kommunikation vor den ich morgen Nachmittag habe in der

Schule für Sozialbetreuungsberufe

Mittwoch, 3. April 2019

Themenabende UK

ich kann euch diese Seite sehr empfehlen ich habe sie vor ein paar Wochen gefunden und ich empfehle sie sehr das ist sowas ähnliches wie Online Webinare von Prentke Romich

https://themenabend-uk.pinecast.co/?fbclid=IwAR3DvURl7SKP0ni4G7p8-VrrWUQv5CQYJJgUBt09qceqzZi2Jl_IxqVep3gwer Lust hat reinzuhören hier der Link

https://themenabend-uk.pinecast.co/?fbclid=IwAR3DvURl7SKP0ni4G7p8-VrrWUQv5CQYJJgUBt09qceqzZi2Jl_IxqVep3gwer Lust hat reinzuhören hier der Link

Abonnieren

Posts (Atom)